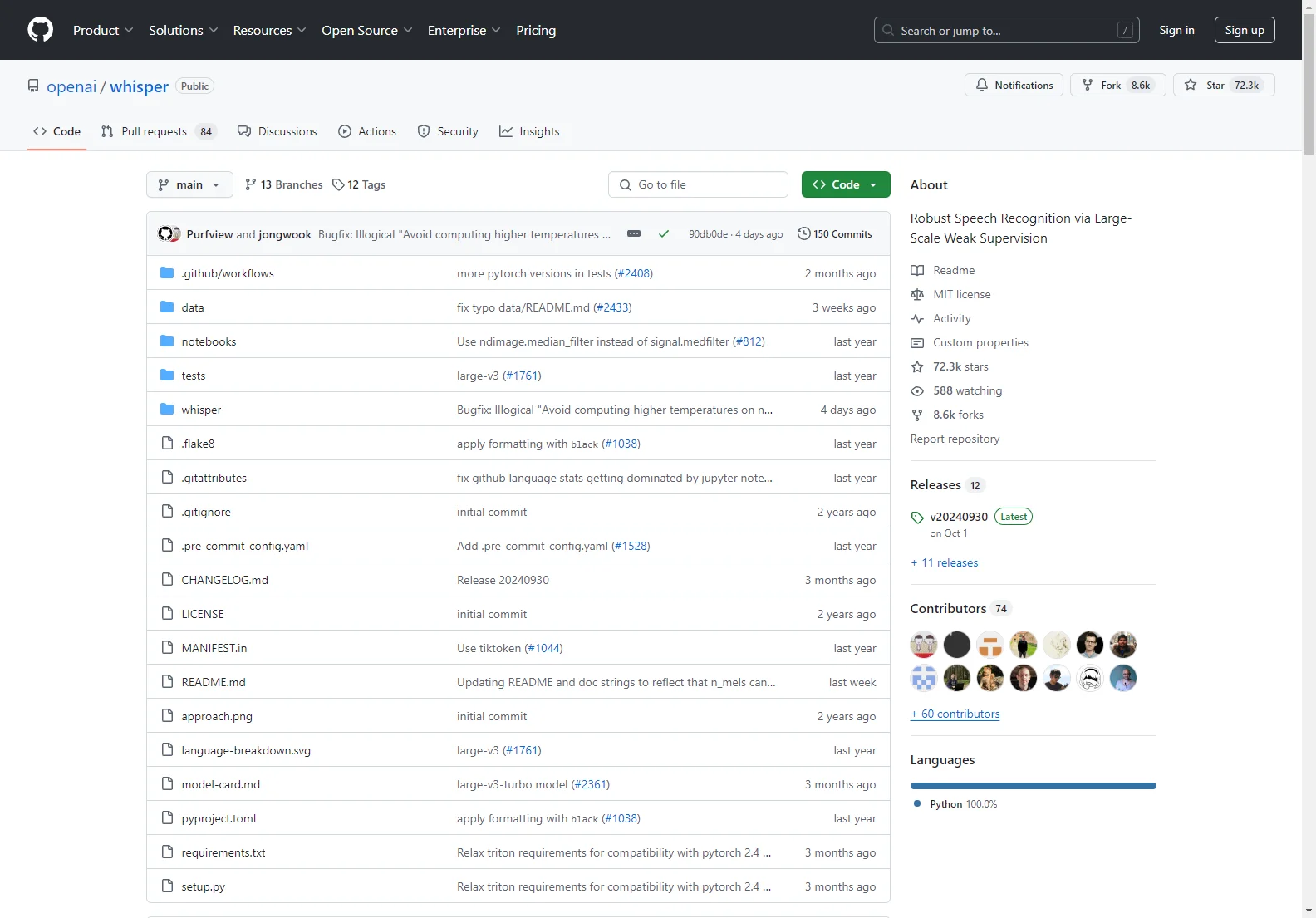

openai/whisper : Un modèle de reconnaissance vocale innovant

openai/whisper est un modèle de reconnaissance vocale de pointe. Il est entraîné sur un vaste ensemble de données audio diverses et est capable de réaliser plusieurs tâches, telles que la reconnaissance vocale multilingue, la traduction vocale et l'identification linguistique.

Caractéristiques clés :

- Un modèle Transformer séquence-à-séquence est formé sur diverses tâches de traitement de la parole.

- Le format d'entraînement multitâche permet à un seul modèle de remplacer plusieurs étapes d'un pipeline traditionnel de traitement de la parole.

Installation et configuration :

- Pour l'installer, il est recommandé d'utiliser Python 3.9.9 et PyTorch 1.10.1. Cependant, le codebase est censé être compatible avec les versions de Python 3.8 à 3.11 et les versions récentes de PyTorch.

- L'installation nécessite également quelques packages Python, notamment tiktoken d'OpenAI pour son implémentation de tokenizer rapide.

- De plus, l'outil de ligne de commande ffmpeg doit être installé sur votre système.

Modèles et langues disponibles :

- Il existe six tailles de modèles, dont quatre avec des versions anglaises uniquement, offrant des compromis entre vitesse et précision.

- La performance de Whisper varie en fonction de la langue.

Utilisation en ligne de commande et en Python :

- Vous pouvez transcrire la parole dans des fichiers audio en utilisant la commande whisper avec l'option --model pour spécifier le modèle.

- En Python, la transcription peut également être effectuée en chargeant le modèle et en utilisant la méthode transcribe().

openai/whisper offre une solution robuste et polyvalente pour la reconnaissance vocale, ouvrant de nombreuses possibilités d'applications dans divers domaines.