ALBERT : Un outil innovant pour l'apprentissage des représentations linguistiques

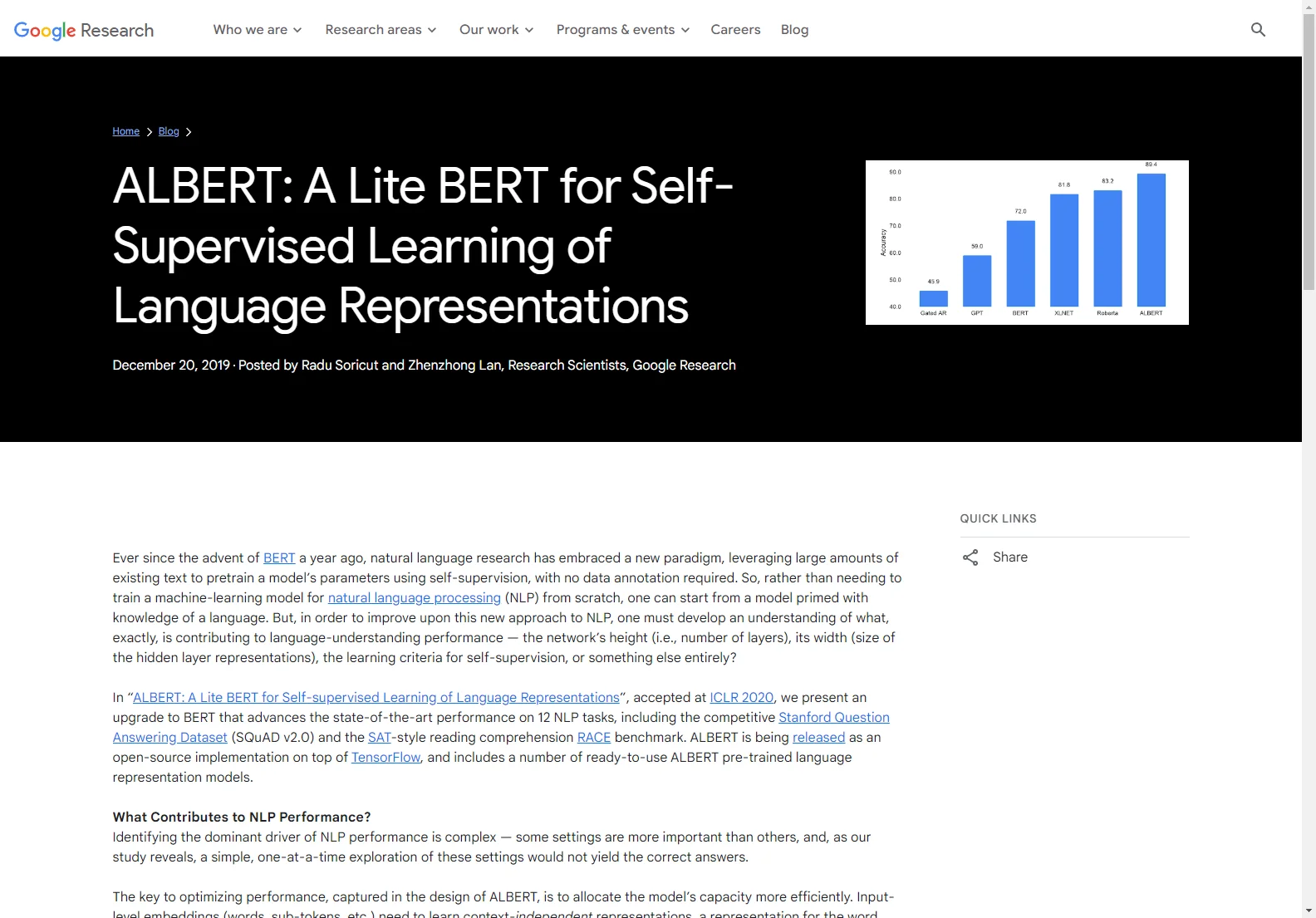

Depuis l'arrivée de BERT il y a un an, la recherche en langage naturel a adopté un nouveau paradigme. ALBERT, présenté dans cet article, est une amélioration de BERT. Il permet de progresser dans la performance sur 12 tâches de NLP.

L'optimisation de la performance d'ALBERT repose sur une allocation plus efficace de la capacité du modèle. Les embeddings au niveau de l'entrée doivent apprendre des représentations indépendantes du contexte, tandis que les embeddings des couches cachées doivent les affiner en fonction du contexte.

Une autre décision de conception cruciale pour ALBERT est l'élimination de la redondance en partageant les paramètres entre les couches. Cette approche réduit légèrement la précision, mais le gain en compacité en vaut la peine.

En mettant en œuvre ces deux changements de conception ensemble, ALBERT obtient une réduction de 89% des paramètres par rapport au modèle BERT-base, tout en atteignant des performances respectables.

Pour évaluer la capacité de compréhension du langage d'un modèle, on peut utiliser le dataset RACE. Les résultats d'ALBERT sur ce dataset montrent l'importance de développer des représentations contextuelles robustes et à haute capacité.