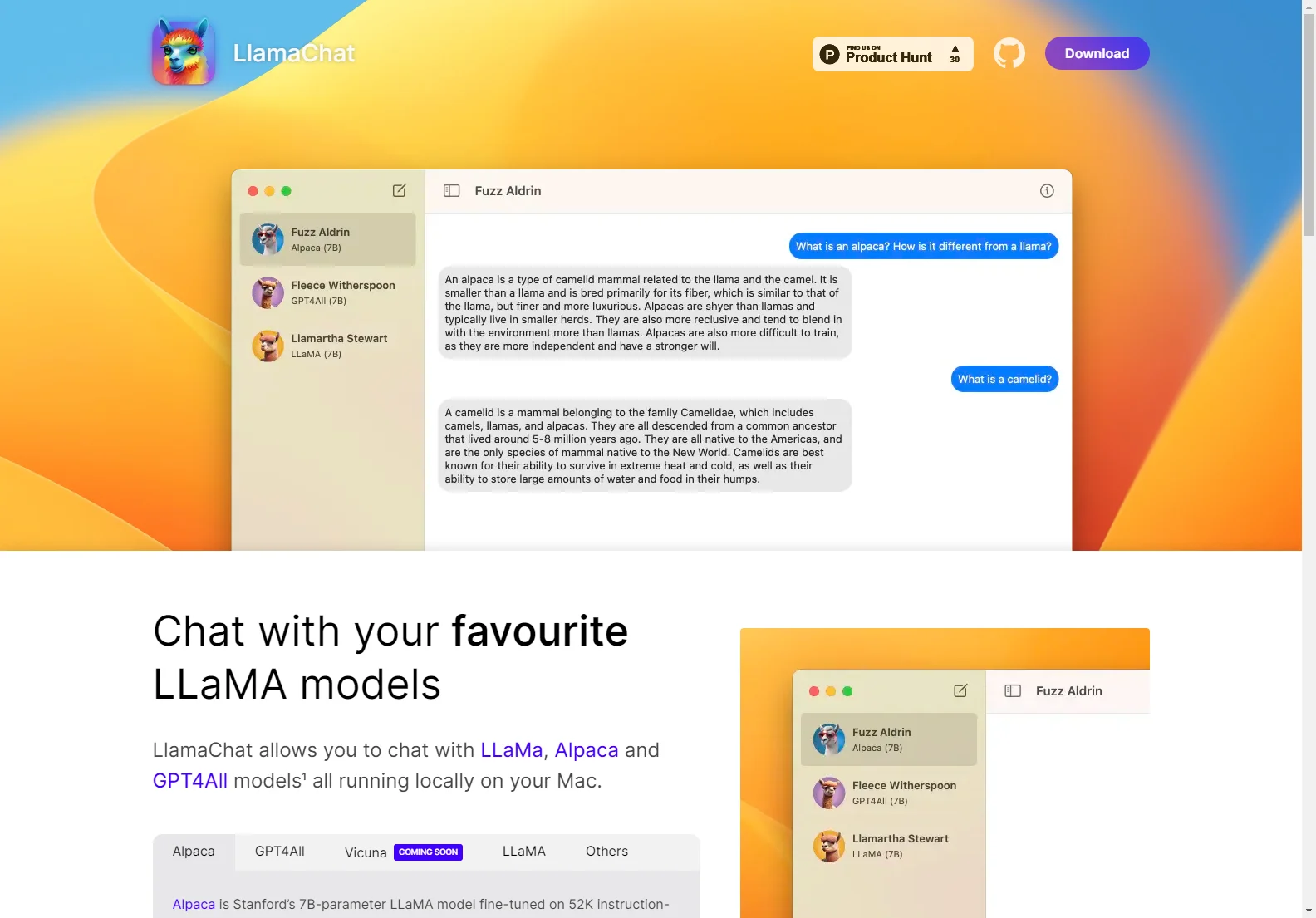

LlamaChat - Die lokale Chat-Option

LlamaChat bietet eine interessante Möglichkeit, mit verschiedenen LLaMA-Modellen wie LLaMa, Alpaca und GPT4All zu chaten. Diese Modelle laufen lokal auf Ihrem Mac, was eine besondere Erfahrung bietet.

Kernfunktionen:

- Unterstützt mehrere Modelle: Neben LLaMa und Alpaca wird auch die bald kommende Vicuna unterstützt. Zudem gibt es die Option für andere Modelle.

- Feinabstimmung: Die Alpaca-Modell, das eine 7B-Parameter-LLaMA-Modell von Stanford ist, wurde anhand von 52K Anleitungen zur Befolgung von Instruktionen, die aus OpenAI's text-davinci-003 generiert wurden, feinabgestimmt. Dies ermöglicht eine chatbot-ähnliche Erfahrung im Vergleich zum ursprünglichen LLaMA-Modell.

Einfache Modellkonvertierung: LlamaChat kann rohe veröffentlichte PyTorch-Modell-Checkpunkte direkt importieren oder Ihre vorab konvertierten.ggml-Modelldateien. Dies erleichtert die Nutzung verschiedener Modelle.

Vollständig Open-Source: LlamaChat wird von Open-Source-Bibliotheken wie llama.cpp und llama.swift angetrieben. Es ist zu 100% kostenlos und wird es auch immer bleiben. Sie können es auf GitHub einsehen. Beachten Sie, dass LlamaChat nicht mit Modelldateien ausgeliefert wird. Sie sind für den Erwerb und die Integration der entsprechenden Modelldateien gemäß den jeweiligen Bedingungen der Anbieter verantwortlich.

LlamaChat ist eine unabhängige Anwendung und ist nicht mit Meta Platforms, Inc., Leland Stanford Junior University oder Nomic AI, Inc. verbunden, unterstützt oder gesponsert. Die Nutzung von LlamaChat mit künstlicher Intelligenz-Modellen oder anderem geistigem Eigentum, das von diesen Einheiten entwickelt wurde, stellt keine Form der Partnerschaft oder Zusammenarbeit dar.