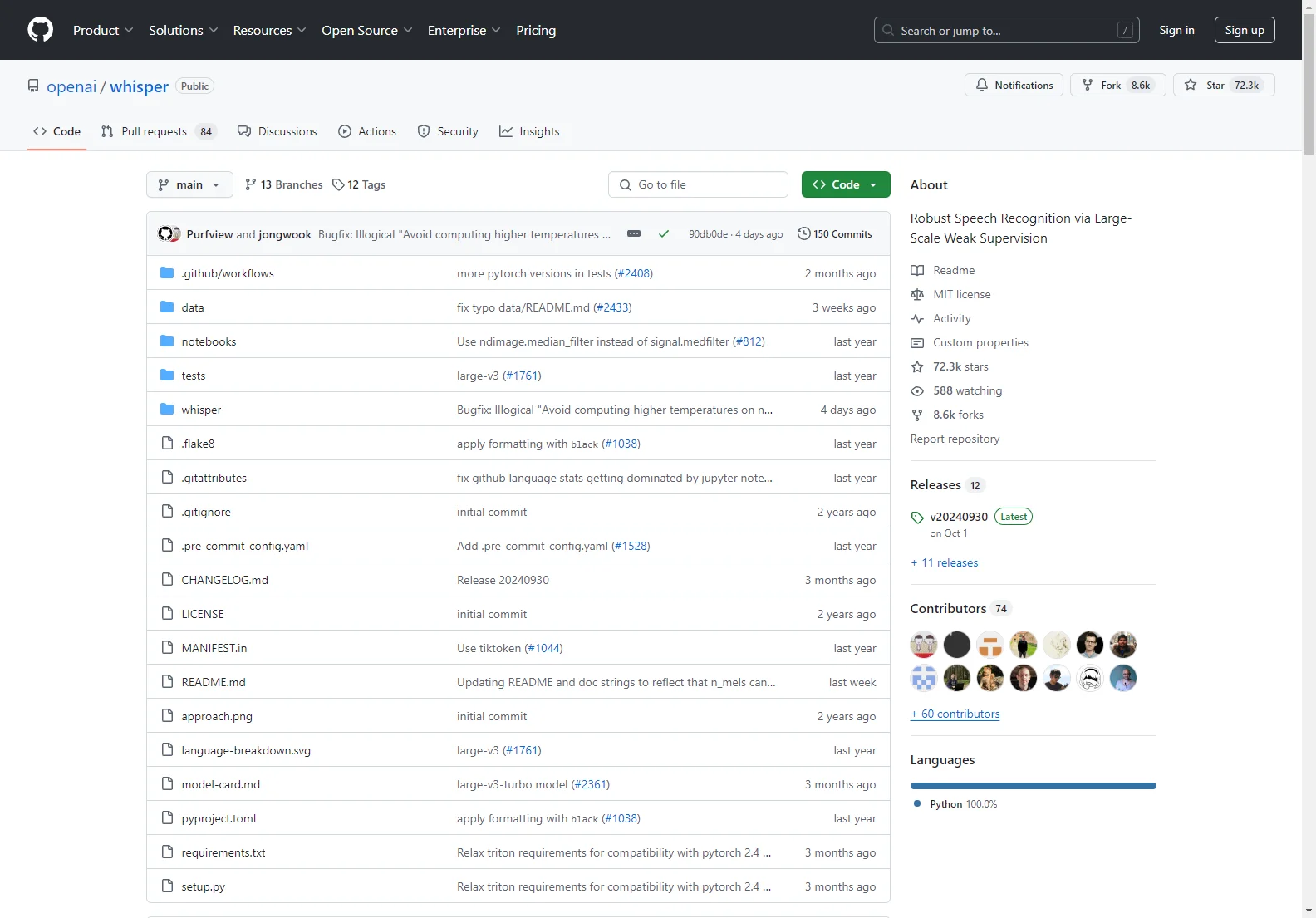

openai/whisper: Um Modelo de Reconhecimento de Fala Avançado

openai/whisper é um modelo de reconhecimento de fala de propósito geral. Ele é treinado em um grande conjunto de dados de áudio diversos e é também um modelo multitarefa que pode realizar reconhecimento de fala multilingue, tradução de fala e identificação de linguagem.

Recursos Principais:

- Um modelo Transformer sequence-to-sequence treinado em várias tarefas de processamento de fala.

- Capaz de substituir muitas etapas de um pipeline tradicional de processamento de fala.

Configuração:

- Requer Python 3.9.9 e PyTorch 1.10.1, mas é compatível com outras versões.

- Depende de alguns pacotes Python, incluindo o tiktoken da OpenAI.

- Precisa do comando ffmpeg instalado no sistema.

Modelos Disponíveis e Línguas:

- Existem seis tamanhos de modelos, com versões apenas em inglês e multilingues.

- O desempenho varia dependendo da linguagem.

Uso via Linha de Comando:

- Pode transcrever fala em arquivos de áudio usando comandos específicos.

Uso em Python:

- Permite a transcrição dentro do Python com funções específicas.

openai/whisper oferece uma solução robusta para o reconhecimento de fala, abrindo novas possibilidades em diversas áreas de aplicação.