ALBERT: Um modelo inovador para aprendizado de linguagem

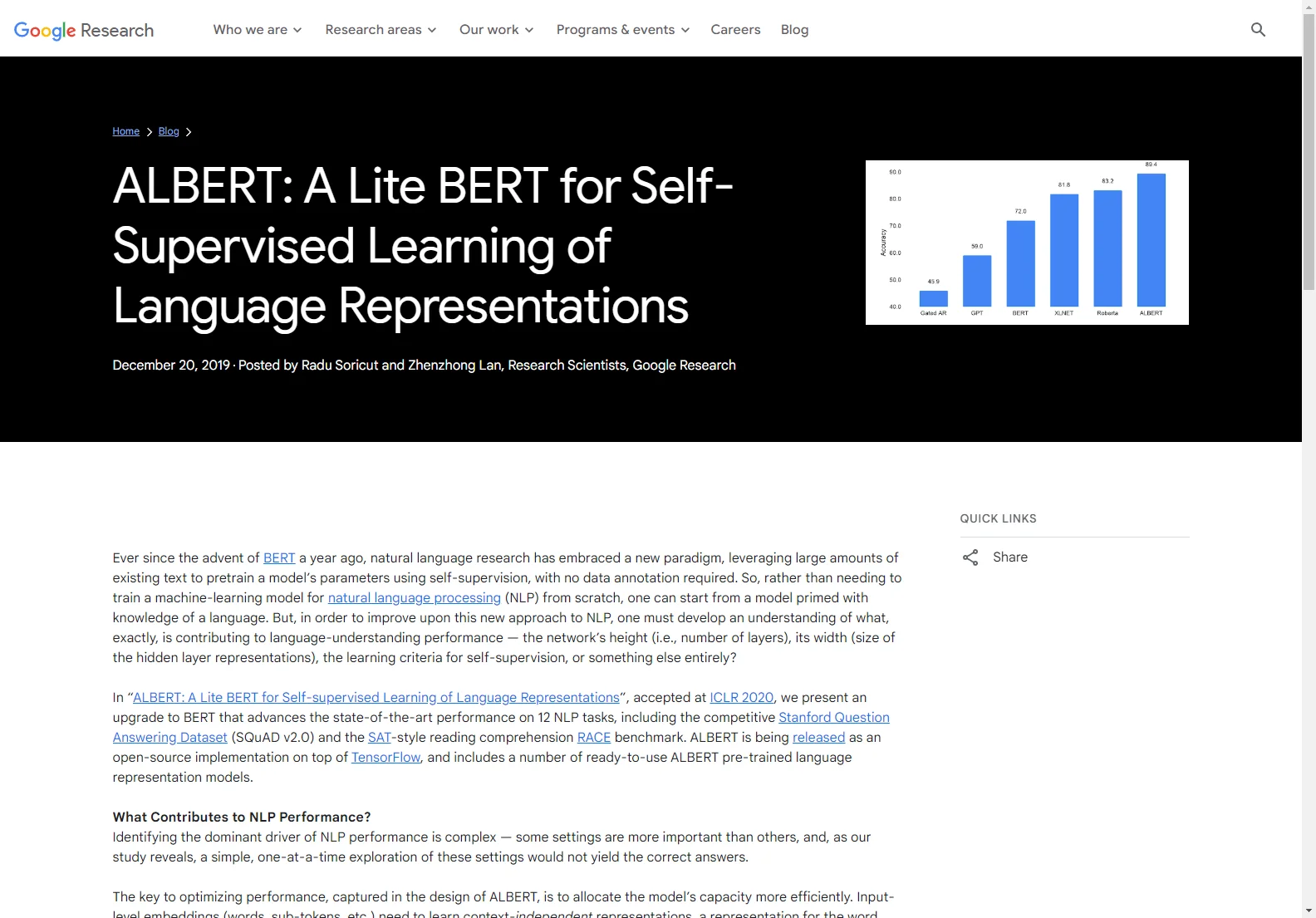

ALBERT é uma importante contribuição para o campo do processamento de linguagem natural (NLP). Ele é uma atualização do BERT que busca aprimorar o desempenho em várias tarefas. A chave para a otimização do desempenho do ALBERT está na alocação mais eficiente da capacidade do modelo. Isso é alcançado por meio da fatorização da parametrização de incorporação, reduzindo os parâmetros do bloco de projeção. Além disso, a partilha de parâmetros nas camadas elimina uma possível redundância, embora isso leve a uma ligeira diminuição na precisão. No entanto, o tamanho mais compacto compensa essa pequena queda. Com essas duas mudanças de design juntas, o ALBERT-base reduz 89% dos parâmetros em comparação com o BERT-base, ainda alcançando um desempenho respeitável. Além disso, ao aumentar o tamanho das incorporações de camada oculta, o ALBERT-xxlarge consegue ganhos significativos de desempenho. Esses resultados mostram a importância de desenvolver representações contextuais robustas e de alta capacidade para uma compreensão precisa da linguagem.