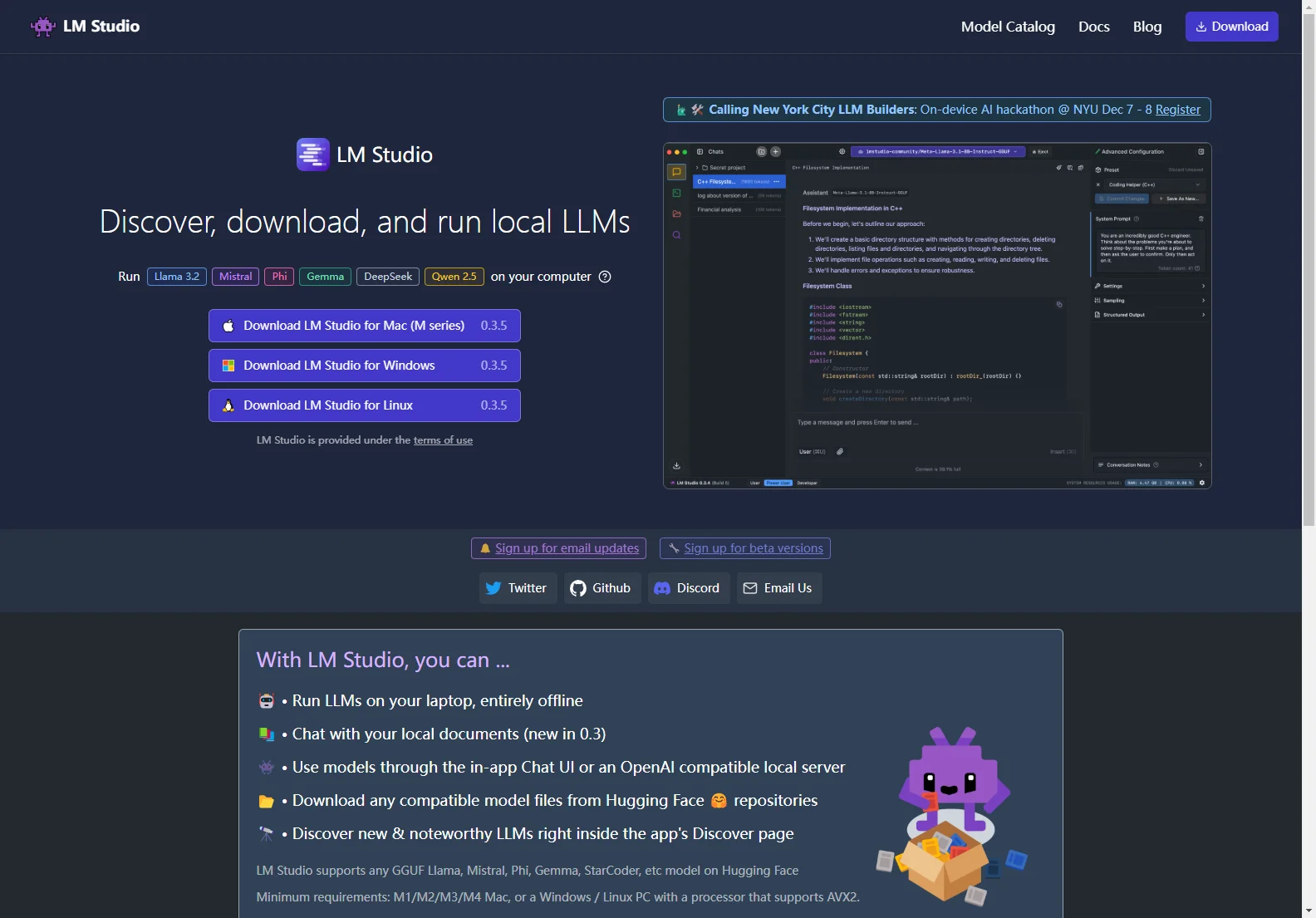

LM Studio - Die Lösung für lokale LLMs

LM Studio bietet eine vielseitige Plattform für die Nutzung lokaler Language Learning Models (LLMs). Mit diesem Tool können Sie verschiedene Aufgaben erledigen. Überblick: LM Studio ermöglicht es Ihnen, LLMs auf Ihrem Laptop vollständig offline auszuführen. Sie können auch mit Ihren lokalen Dokumenten chatten, was eine neue Funktion in der Version 0.3 ist. Darüber hinaus können Sie Modelle über die in der App integrierte Chat-Benutzeroberfläche oder einen OpenAI-kompatiblen lokalen Server nutzen. Kernfunktionen: Sie können beliebige kompatible Modelldateien von Hugging Face-Repositories herunterladen. Außerdem können Sie neue und bemerkenswerte LLMs direkt auf der Entdeckungsseite der App entdecken. Grundlegende Nutzung: LM Studio unterstützt eine Vielzahl von GGUF-Modellen wie Llama, Mistral, Phi, Gemma, StarCoder usw. auf Hugging Face. Die Mindestanforderungen sind ein M1/M2/M3/M4-Mac oder ein Windows/Linux-PC mit einem Prozessor, der AVX2 unterstützt. LM Studio wurde dank des llama.cpp-Projekts möglich gemacht. Das Team erweitert sich derzeit. Informationen zu offenen Stellen finden Sie auf der Karriere-Seite. Die technische Dokumentation finden Sie unter . Häufig gestellte Fragen werden beantwortet, z. B. dass die App keine Daten sammelt und Ihre Daten privat und lokal auf Ihrem Gerät bleiben. Für die geschäftliche Nutzung können Sie das Anfrageformular ausfüllen.