VHellendoorn/Code-LMs: Eine Einführung

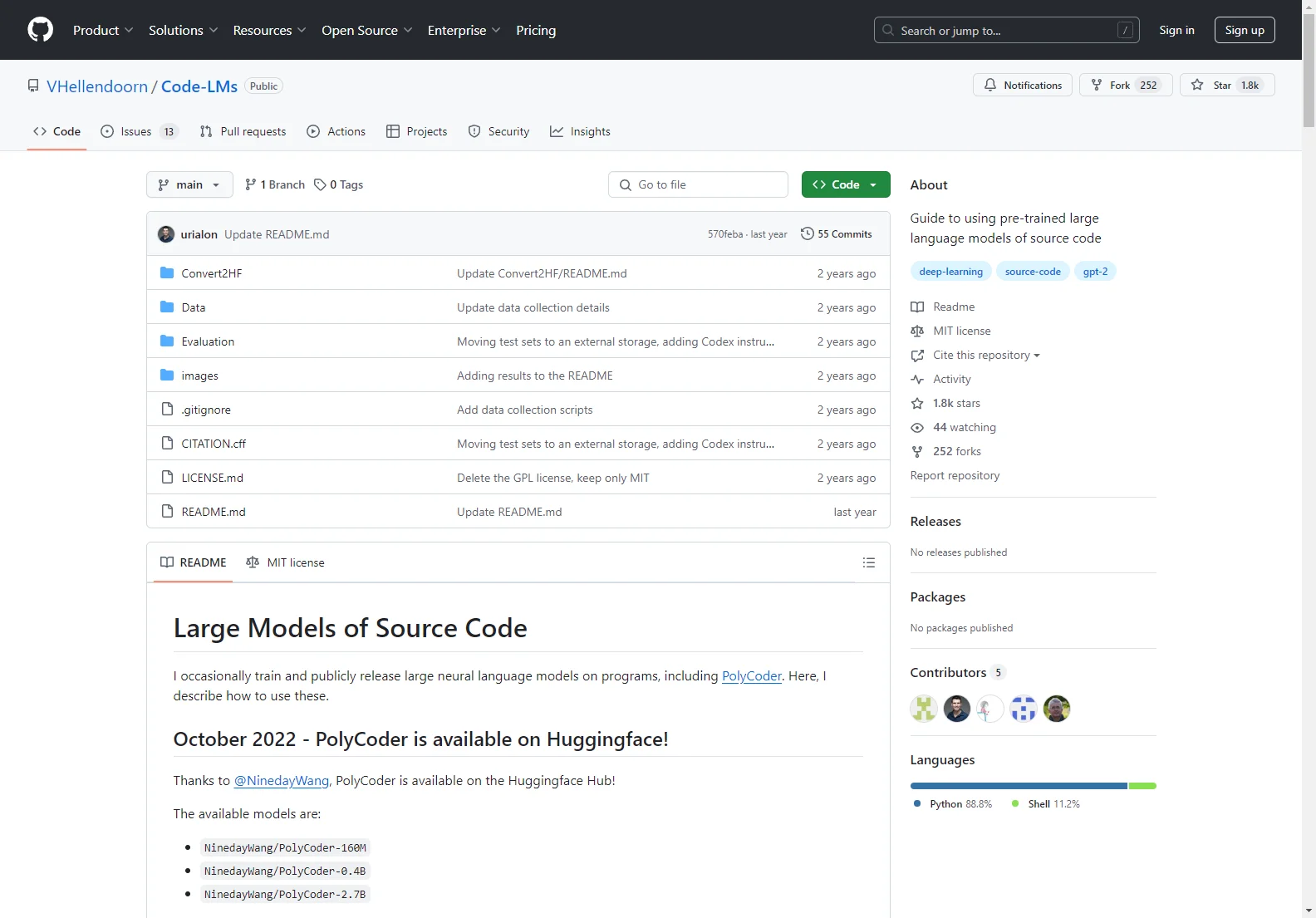

VHellendoorn/Code-LMs bietet eine praktische Anleitung zur Verwendung vorgebildeter großer Sprachmodelle für Quellcode. Dieses Projekt umfasst verschiedene Aspekte, darunter die Beschreibung der verfügbaren Modelle, die Erklärung des Trainingsverfahrens sowie die Diskussion über die Datensätze und die Evaluierungsmethoden.

Verfügbare Modelle: In diesem Projekt sind mehrere Modelle verfügbar, darunter Modelle mit verschiedenen Parametern und für verschiedene Programmiersprachen. Zum Beispiel gibt es das 2.7B-Parameter-Modell (PolyCoder), das 405M-Parameter-Modell und das 160M-Parameter-Modell.

Trainingsprozess: Das Training wurde auf 4 bis 8 NVIDIA RTX 8000 GPUs durchgeführt. Dabei wurden die Standardkonfigurationswerte weitgehend befolgt, mit einigen Anpassungen in Bezug auf die Batch-Größe, die Datenaufteilung und andere Parameter.

Datensätze: Ein 249GB großer mehrsprachiger Korpus wurde verwendet, um PolyCoder zu trainieren. Dieser Korpus wurde aus den beliebtesten Repositorys für 12 Programmiersprachen extrahiert und durch verschiedene Filterungsschritte verarbeitet.

Evaluierung: Es gibt detaillierte Anweisungen zur Replikation der Perplexitäts- und HumanEval-Ergebnisse. Die Ergebnisse zeigen die Leistung der Modelle in verschiedenen Aufgaben und im Vergleich zu anderen bekannten Modellen.