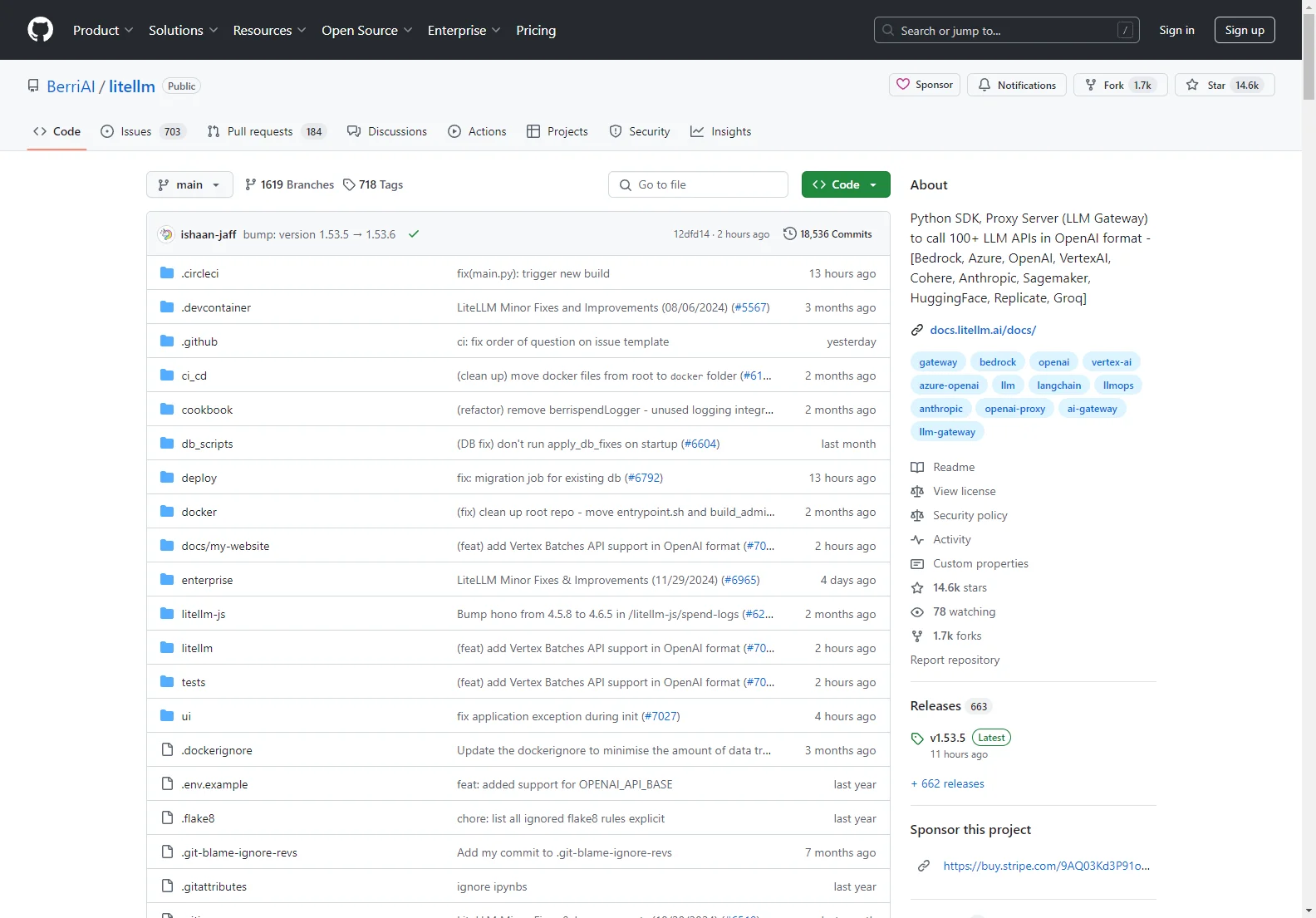

BerriAI/litellm: Uma Solução Avançada para Chamadas de APIs LLM

BerriAI/litellm é uma ferramenta poderosa que traz diversas vantagens para os usuários. Ele atua como um SDK Python e um servidor proxy (LLM Gateway), permitindo a chamada de mais de 100 APIs LLM no formato OpenAI. Isso inclui nomes importantes da indústria, como Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate e Groq.

Recursos Principais:

- Tradução de Entradas: Transforma as entradas para os endpoints de conclusão, incorporação e geração de imagens dos provedores.

- Saída Consistente: Garante que as respostas de texto estejam sempre disponíveis em ['choices'][0]['message']['content'].

- Lógica deRetry e fallback: Através de múltiplas implantações, como Azure/OpenAI, aumentando a confiabilidade.

Modos de Uso:

- Uso Síncrono: Exemplos de como fazer chamadas para modelos como o GPT-3.5-turbo e o Command-Nightly.

- Uso Assíncrono: Mostra como realizar chamadas assíncronas para obter respostas mais rápidas.

- Streaming: Suporta o streaming da resposta do modelo, fornecendo uma experiência de interação em tempo real.

Observabilidade e Logging: Expõe callbacks predefinidos para enviar dados a várias ferramentas de monitoramento, como Lunary, Langfuse, DynamoDB, s3 Buckets, Helicone, Promptlayer, Traceloop, Athina e Slack.

Servidor Proxy (LLM Gateway): Oferece vantagens como ganchos para autenticação, registro, rastreamento de custos e limitação de taxa.

Com BerriAI/litellm, os usuários têm acesso a uma solução abrangente e eficiente para trabalhar com múltiplas APIs LLM, simplificando o processo e aumentando a produtividade.