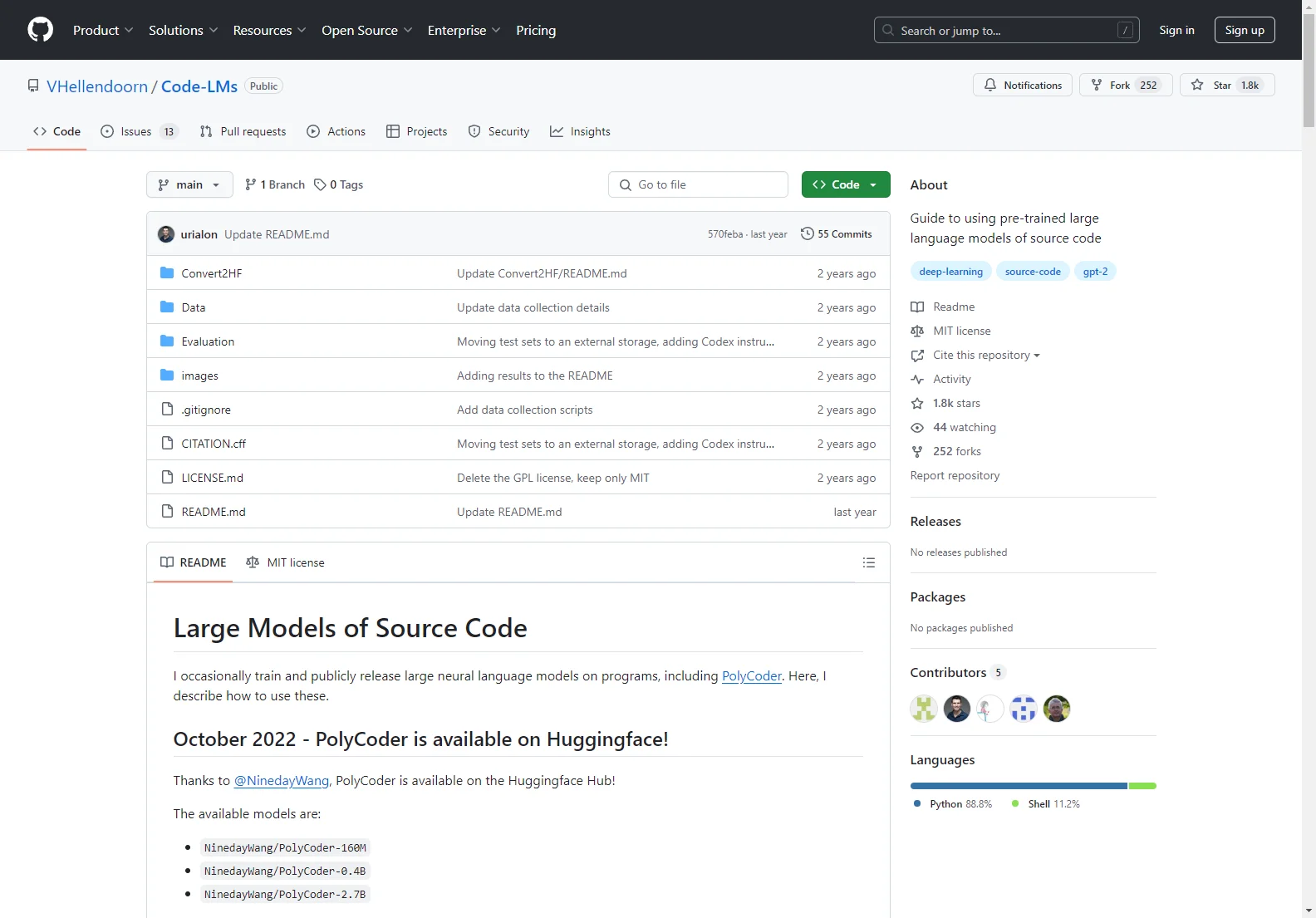

ソースコードの事前学習済み大規模言語モデルの利用ガイド

VHellendoorn/Code-LMs は、ソースコードに関する大規模な神経言語モデルを訓練し、公開しています。ここでは、これらのモデルの使用方法について説明します。

セットアップ モデル(PolyCoder を含む)の訓練には GPT NeoX ツールキットが使用されています。事前学習済みのチェックポイントをダウンロードし、Docker イメージまたはソースからのフォークを使用してコードを生成したり、評価を再現したりできます。

モデルの取得 訓練用のチェックポイントファイルは公開の Zenodo リポジトリにホストされています。現在利用可能なモデルには、NinedayWang/PolyCoder-160M、NinedayWang/PolyCoder-0.4B、NinedayWang/PolyCoder-2.7B などがあります。

コード生成 コードの生成には特定のコマンドを使用できます。デフォルトでは、インタラクティブなプロンプトが作成され、比較的短い出力(256 トークン)が生成されます。

多言語モデル 12 のプログラミング言語にまたがる大規模なコーパスで訓練されたいくつかのモデルがあります。

訓練プロセス 訓練は 4 ~ 8 つの NVIDIA RTX 8000 GPU で行われ、標準的な設定値に従っていますが、パフォーマンス向上のためにいくつかの設定が変更されています。

データセット 249GB の多言語コーパスが PolyCoder の訓練に使用されています。

評価 詳細な説明は公開の NeoX リポジトリで確認できます。