Stable Diffusion 3 : Un Modèle de Génération d'Images Innovant

Stable Diffusion 3 est le dernier modèle de génération d'images texte en image développé par Stability AI. Il offre des améliorations significatives en termes de fidélité d'image, de gestion de plusieurs sujets et d'adhérence au texte.

Le modèle s'appuie sur l'architecture du Multimodal Diffusion Transformer (MMDiT), avec des poids distincts pour les représentations d'image et de langage. Il est accessible via différentes voies, telles que l'API Stable Diffusion 3, les options de téléchargement et les plateformes en ligne.

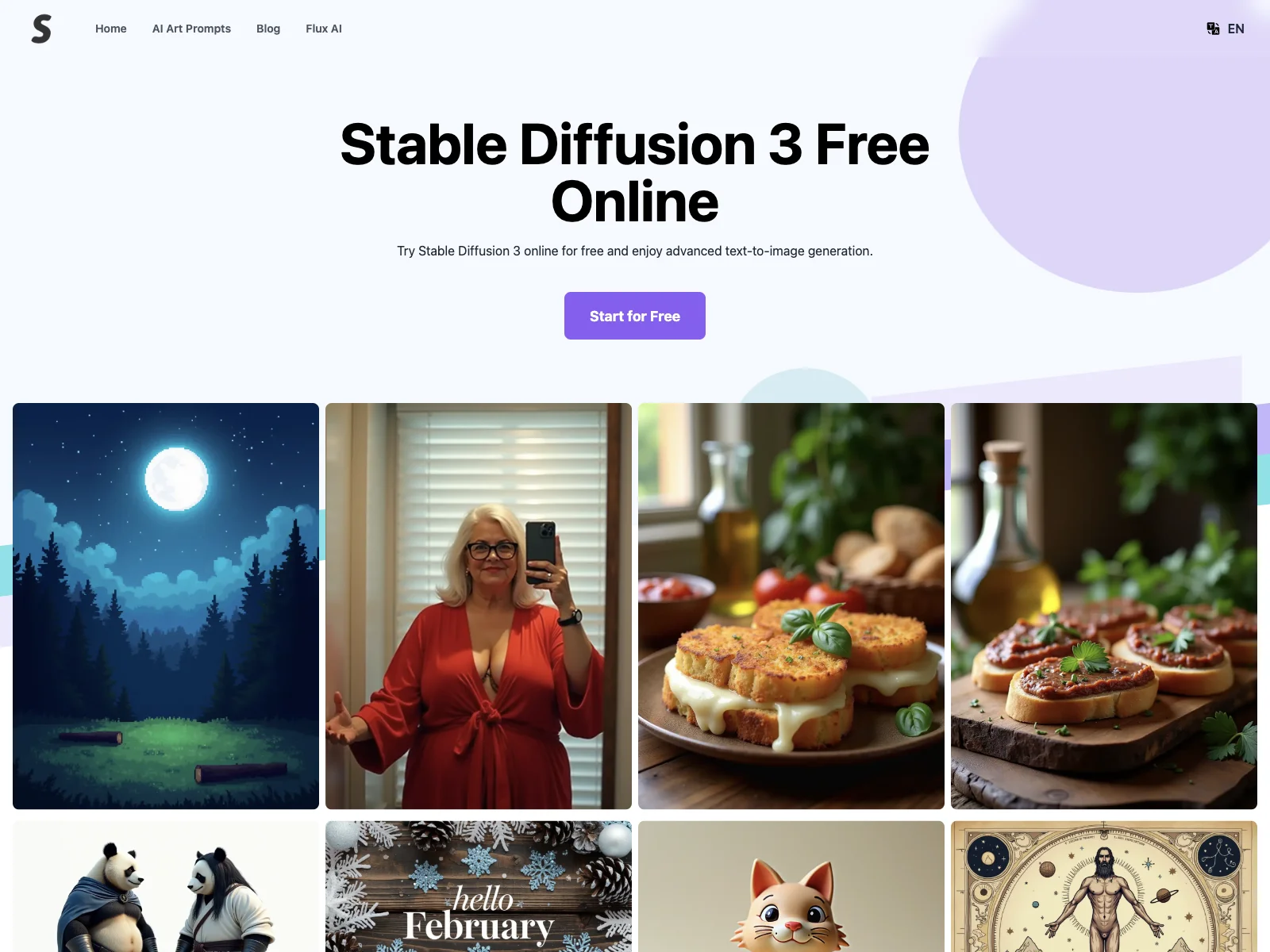

Sur le site stablediffusion3.net, les utilisateurs peuvent expérimenter Stable Diffusion 3 gratuitement pour comprendre ses capacités. Avec un quota gratuit disponible, ils peuvent explorer comment l'utiliser et comparer Stable Diffusion 3 avec d'autres modèles.

Comment Stable Diffusion 3 fonctionne? Il exploite l'architecture du Diffusion Transformer (DiT), intégrant des prédicteurs de bruit avancés et des techniques d'échantillonnage pour produire des images de haute qualité. Le modèle utilise des poids spécifiques pour garantir une génération de texte précise et cohérente dans les images.

Avec des modèles allant de 800M à 8B de paramètres, Stable Diffusion 3 offre une scalabilité pour répondre aux différentes capacités matérielles et aux besoins de performance.