MagicAnimate : Un outil révolutionnaire pour l'animation d'images humaines

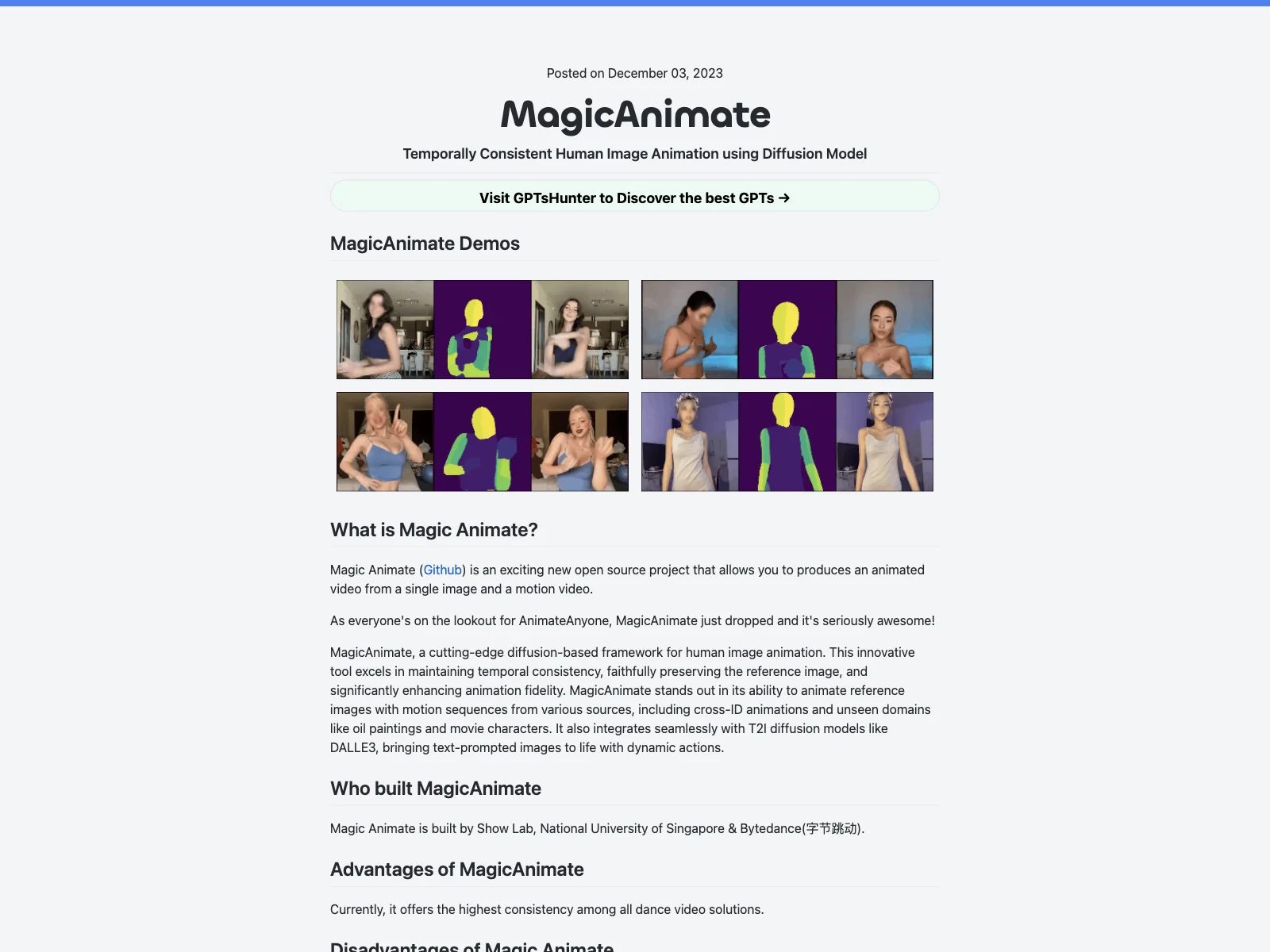

MagicAnimate est un projet open source passionnant. Il permet de produire une vidéo animée à partir d'une seule image et d'une vidéo de mouvement. Ce cadre basé sur la diffusion est à la pointe de la technologie et excelle dans le maintien de la cohérence temporelle. Il préserve fidèlement l'image de référence et améliore considérablement la fidélité de l'animation.

Les créateurs de MagicAnimate sont Show Lab, l'Université nationale de Singapour et Bytedance. Actuellement, il offre la plus haute cohérence parmi toutes les solutions de vidéo de danse. Cependant, il présente quelques inconvénients, tels que certaines distorsions au niveau du visage et des mains, et un changement de style de l'anime au réalisme, particulièrement perceptible sur les visages dans les vidéos.

Pour commencer à utiliser MagicAnimate, téléchargez les modèles de base pré-entraînés pour StableDiffusion V1.5 et VAE finement ajusté MSE. Téléchargez également les points de contrôle de MagicAnimate. Les prérequis d'installation sont : python >= 3.8, CUDA >= 11.3 et ffmpeg. Vous pouvez installer avec conda en suivant les instructions : conda env create -f environment.yml et conda activate manimate.

Vous pouvez également essayer la démo en ligne de MagicAnimate sur Huggingface, Replicate ou Colab. Pour générer une vidéo animée, vous pouvez utiliser l'API Replicate en suivant les paramètres spécifiés.

Pour générer une vidéo de mouvement ou convertir une vidéo en vidéo de mouvement, vous pouvez utiliser OpenPose, une bibliothèque de détection de points clés en temps réel pour l'estimation du corps, du visage, des mains et des pieds.