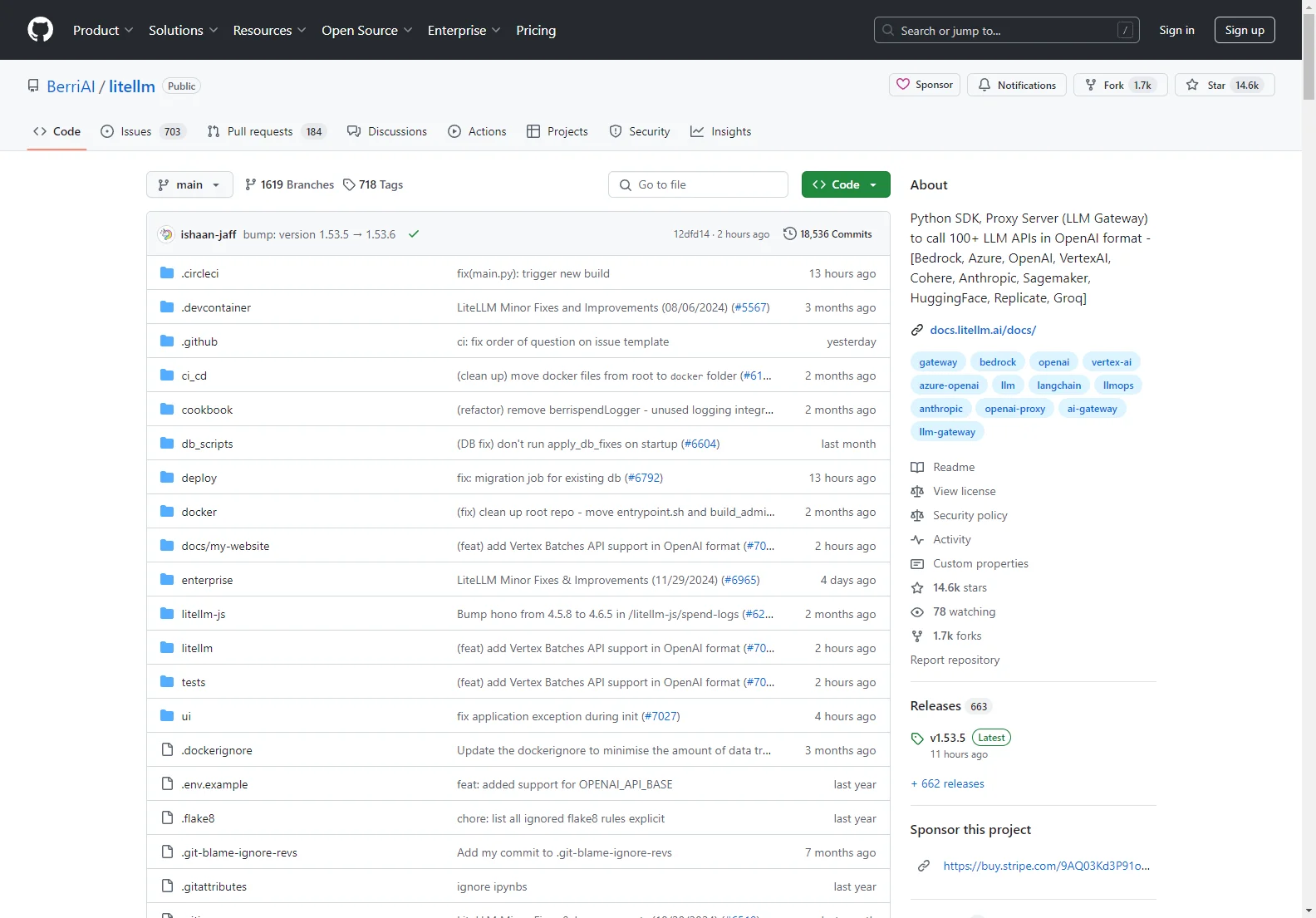

h2 BerriAI/litellm : Un outil puissant pour les API LLM

BerriAI/litellm est une solution innovante qui offre aux utilisateurs la possibilité de travailler avec une variété d'APIs LLM. Ce SDK Python et serveur proxy LLM permet de faire des appels à plus de 100 APIs LLM au format OpenAI, incluant des noms bien connus tels que Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate et Groq.

Fonctionnalités clés :

- Traduction d'entrées : Il traduit les entrées vers les points de terminaison de complétion, d'embedding et de génération d'images des fournisseurs.

- Sortie cohérente : Les réponses textuelles sont toujours disponibles de manière cohérente.

- Logique de retry et de fallback : Il assure une gestion efficace en cas de problèmes de déploiement.

Utilisation :

L'installation est simple avec pip install litellm. Les utilisateurs peuvent ensuite définir des variables d'environnement pour les clés API et effectuer des appels à des modèles tels que gpt-3.5-turbo ou command-nightly. Le support de l'asynchrone, du streaming et de l'observabilité est également mis en avant, offrant une expérience utilisateur complète et flexible.

Proxy Server (LLM Gateway) : Le proxy fournit des fonctionnalités telles que des crochets pour l'authentification, la journalisation, le suivi des coûts et la limitation des taux. Il est facile à démarrer via la CLI et peut être utilisé avec des outils tels que Langchain, OpenAI SDK et d'autres.