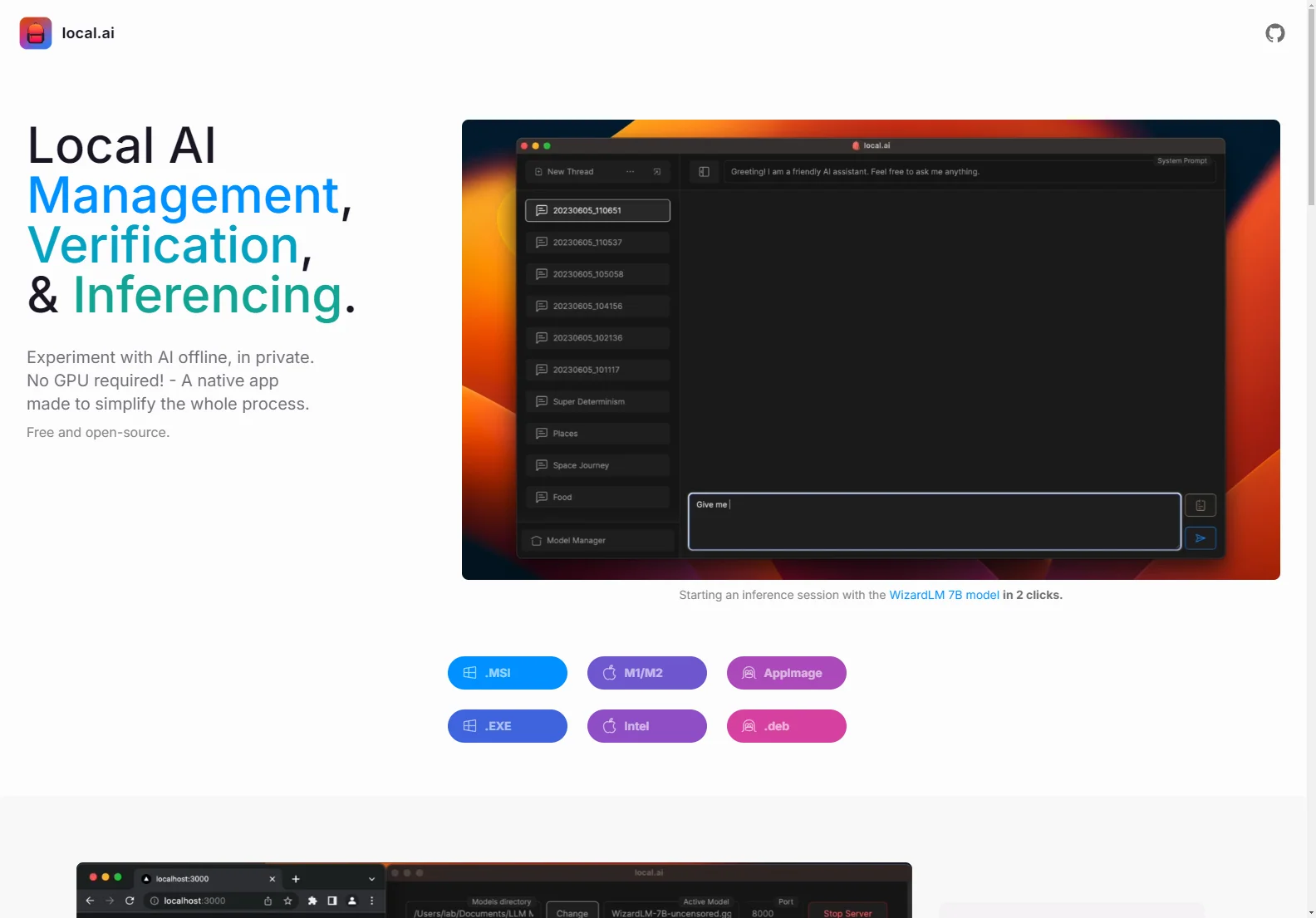

local.ai - Die Lösung für AI-Management offline

local.ai ist eine beeindruckende native App, die sich darauf spezialisiert, den gesamten Prozess des AI-Managements zu vereinfachen. Mit der Möglichkeit, offline und in Privatsphäre zu experimentieren, benötigt es keine GPU. Die App ist kostenlos und Open-Source, was sie für viele Nutzer attraktiv macht.

Core Features:

- Die App bietet CPU-Inferencing und passt sich den verfügbaren Threads an. Zudem unterstützt sie GGML-Quantisierung in verschiedenen Formaten.

- Mit der Funktion Model Management können Nutzer ihre AI-Modelle an einem zentralen Ort verwalten. Sie können beliebige Verzeichnisse auswählen und es gibt Features wie einen fortsetzbaren, gleichzeitigen Downloader und nutzungsbasierte Sortierung. In Zukunft sind weitere Features wie verschachtelte Verzeichnisse und benutzerdefinierte Sortierung und Suche geplant.

- Die Digest Verification sorgt für die Integrität der heruntergeladenen Modelle mit robusten BLAKE3 und SHA256 Digest-Compute-Funktionen.

- Der Inferencing Server ermöglicht es, in nur zwei Klicks einen lokalen Streaming-Server für AI-Inferencing zu starten. Es gibt Features wie einen Streaming-Server, eine schnelle Inferenz-UI und die Möglichkeit, in.mdx zu schreiben.

Basic Usage: Die Nutzung von local.ai ist einfach und intuitiv. Nutzer können mit wenigen Klicks mit dem Experimentieren beginnen und die verschiedenen Funktionen nutzen, um ihre AI-Erfahrung zu verbessern.