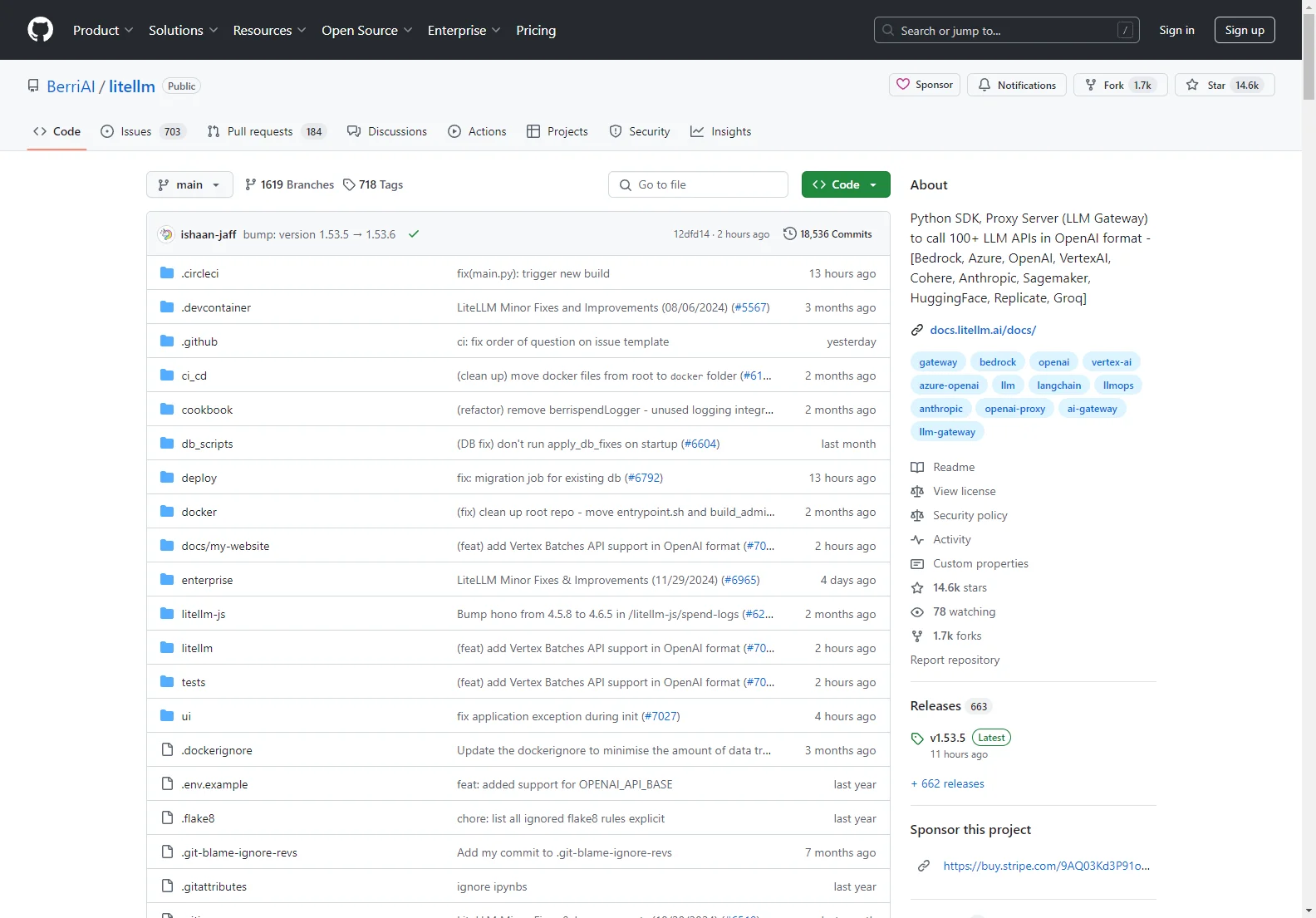

h2 BerriAI/litellm: Ein hammermäßiges Python SDK und Proxy-Server (LLM Gateway)

BerriAI/litellm ist eine top Lösung für die Verwaltung und Nutzung verschiedener Sprachmodell-APIs. Mit der Möglichkeit, mehr als 100 LLM-APIs im OpenAI-Format zu erreichen, vereinfacht es die Interaktion mit diversen KI-Modellen.

Kernfunktionen:

- Übersetzt Eingaben in die entsprechenden Completion-, Embedding- und Image_Generation-Endpunkte der Anbieter.

- Bietet eine geile konsistente Ausgabe, wobei Textantworten immer unter ['choices'][0]['message']['content'] zu finden sind.

- Enthält eine coole Retry-/Fallback-Logik für mehrere Deployments wie Azure/OpenAI.

Grundlegende Nutzung:

- Installation mit

pip install litellm. - Einstellen von Umgebungsvariablen für die API-Schlüssel.

- Beispielaufrufe für verschiedene Modelle wie

gpt-3.5-turboundcommand-nightly.

Das Tool unterstützt auch asynchrone Anfragen, Streaming und bietet Möglichkeiten für die Logging-Observabilität. Darüber hinaus hat es einen Proxy-Server mit Funktionen wie Hooks für Auth, Logging, Kostenverfolgung und Rate Limiting.

BerriAI/litellm macht die Arbeit mit KI-Modellen einfacher und bietet eine effektive Möglichkeit, die Vorteile verschiedener Anbieter zu nutzen.