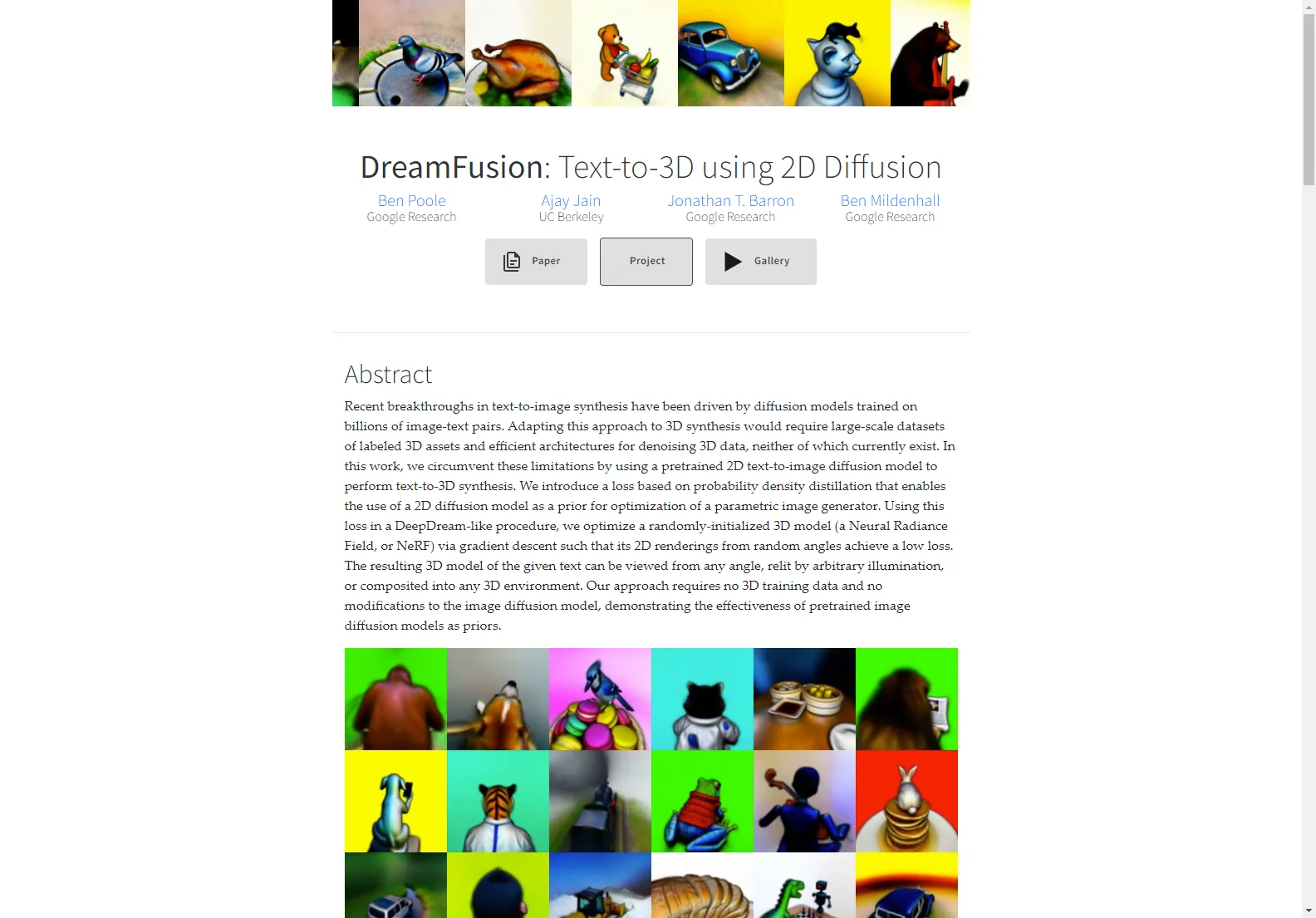

DreamFusion: Text-to-3D mit 2D-Diffusion

DreamFusion ist eine bahnbrechende Technologie in der Welt der 3D-Synthese. Sie nutzt ein vortrainiertes 2D-Text-to-Image-Diffusionsmodell, um Text-to-3D-Synthesen durchzuführen. Dies umgeht die Einschränkungen, die mit der Notwendigkeit großer 3D-Datensätze und effizienter Architekturen für die Entrauschung von 3D-Daten verbunden sind.

Kernfunktionen:

- Verwendet eine Verlustfunktion auf Basis der Probendichtedestillation, um ein 2D-Diffusionsmodell als Vorlage für die Optimierung eines parametrischen Bildgenerators zu nutzen.

- Optimiert ein zufällig initialisiertes 3D-Modell (ein Neural Radiance Field oder NeRF) über Gradientenabstieg, sodass seine 2D-Renderings aus zufälligen Winkeln einen niedrigen Verlust erreichen.

Grundlegende Verwendung:

- Benutzer können mit einer Beschreibung 3D-Objekte mit hoher Treue in Bezug auf Aussehen, Tiefe und Normalen erzeugen.

- Die erzeugten NeRF-Modelle können mit dem Marching-Cubes-Algorithmus in Meshes exportiert werden, um eine einfache Integration in 3D-Renderer oder Modellierungssoftware zu ermöglichen.

DreamFusion zeigt die Wirksamkeit vortrainierter Bild-Diffusionsmodelle als Vorlagen und eröffnet neue Möglichkeiten in der 3D-Synthese.