ALBERT: Eine bahnbrechende Entwicklung in der Sprachmodellierung

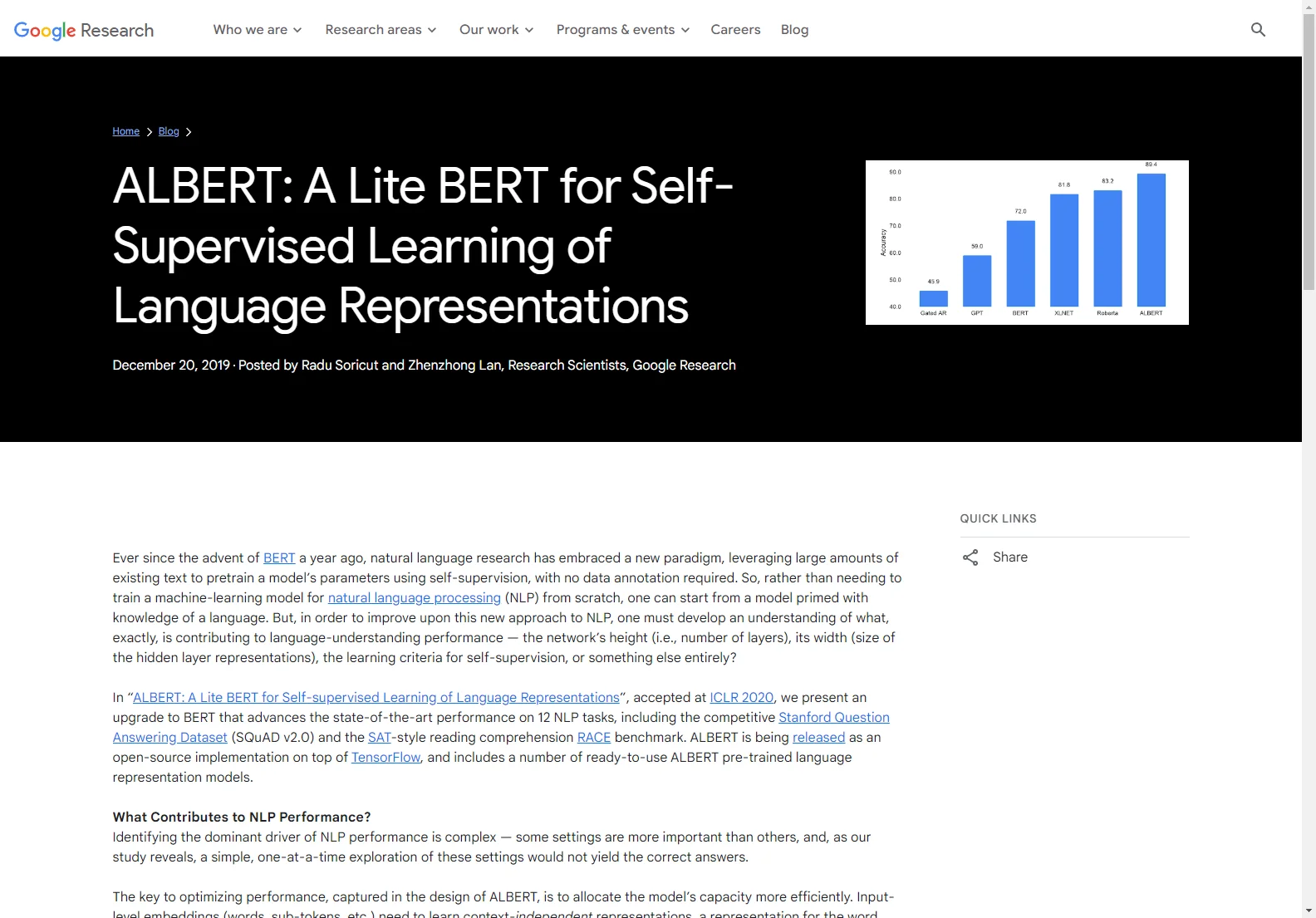

ALBERT ist eine wichtige Weiterentwicklung im Bereich der Selbstüberwachung beim Lernen von Sprachrepräsentationen. Seit der Einführung von BERT hat sich die Forschung in der natürlichen Sprachverarbeitung einem neuen Paradigma zugewandt. ALBERT zeichnet sich durch eine effizientere Allokation der Modellkapazität aus. Durch die Faktorisierung der Embedding-Parametrisierung können die Parameter des Projektionsblocks um 80% reduziert werden, ohne dass die Leistung stark beeinträchtigt wird. Zudem wird eine mögliche Redundanz in Transformer-basierten Netzwerkarchitekturen durch Parameter-Sharing über die Schichten hinweg eliminiert. Dies führt zwar zu einem leichten Verlust an Genauigkeit, aber die kompaktere Größe ist es wert. Zusammen ermöglicht dies ein ALBERT-Basismodell mit nur 12 Millionen Parametern und einer 89%igen Parameterreduktion im Vergleich zum BERT-Basismodell. Mit einer erhöhten Größe der Hidden-Layer-Embeddings erzielt ALBERT zudem signifikante Leistungsgewinne. Die Ergebnisse zeigen, dass eine genaue Sprachverständnisleistung von der Entwicklung robuster, hochkapazitiver kontextueller Darstellungen abhängt. Um die Sprachverständnisfähigkeit eines Modells zu bewerten, kann ein Leseverständnistest wie der RACE-Datensatz verwendet werden. ALBERT erzielt hier herausragende Ergebnisse und setzt einen neuen Stand der Technik.